批量提交数据到MySQL数据库可以通过使用INSERT语句一次性插入多行记录实现。这可以显著提高数据导入效率,减少服务器的I/O操作和网络延迟,特别是在处理大量数据时。

在MySQL数据库中进行批量数据提交是日常数据处理的常见需求,尤其在数据迁移、日志导入等场景下,了解不同的数据提交方法及其适用场景,对于优化数据库性能、提高数据处理效率具有重要意义,本文将围绕MySQL数据库批量提交数据的几种常用方法进行详细解读,并结合实际案例分析各方法的优缺点及适用场景。

(图片来源网络,侵删)

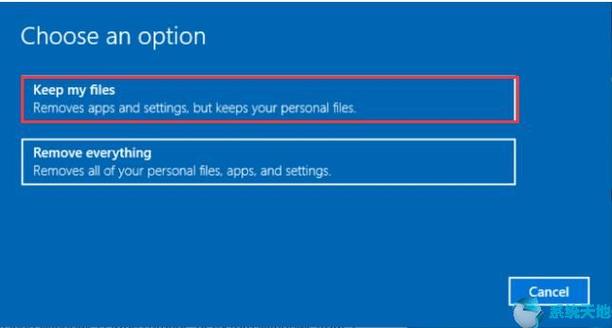

准备工作

在进行大数据量插入前,确保测试环境的稳定性和兼容性是非常重要的,测试环境包括SpringBoot项目、MyBatisPlus框架、MySQL数据库及JDK,选择一个合适的数据集用于测试也很关键,这将直接影响到测试结果的准确性和实用性。

批量数据提交方法

1. for循环单条插入

通过for循环逐条插入数据是最直观的方法,但它的效率较低,每次插入都需要与数据库建立连接、传输数据、提交事务,导致在大量数据插入时效率极低。

2. 拼接SQL语句插入

拼接SQL是将多条插入命令合并成一条SQL语句执行,这可以减少数据库交互次数,提高插入效率,这种方法可能会导致SQL语句过长,超出数据库的最大查询限制。

(图片来源网络,侵删)

3. 批量插入saveBatch()

使用SpringBoot和MyBatis的saveBatch()方法可以实现数据的批量插入,该方法将数据分批次提交,可以有效减少数据库的IO压力,提升插入速度。

4. 开启批处理模式

在开启批处理模式下,可以将多次插入操作累积到一定量后一次性提交,这样大大减少了事务提交的次数,提高了数据处理效率。

5. LOAD DATA INFILE

LOAD DATA INFILE是MySQL提供的一种高效数据加载工具,它可以直接从文件中读取数据并插入到数据库中,避免了网络传输过程,特别适用于大规模数据的导入。

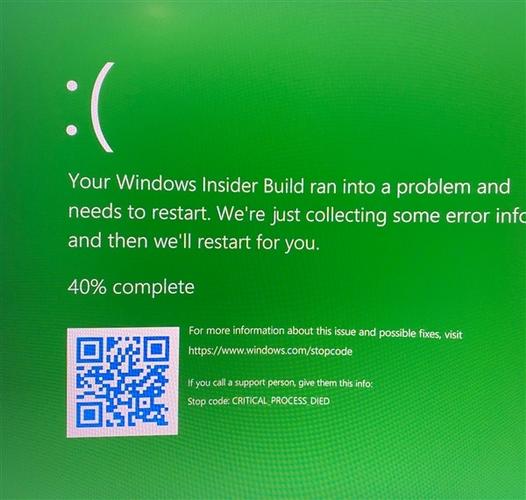

注意事项

(图片来源网络,侵删)

在进行大数据量插入时,还需要注意以下几点:

事务管理:合理安排事务的开启与关闭,避免长时间锁定资源导致的性能问题。

内存管理:注意控制批量操作的数据量,防止因数据量过大而导致的内存溢出问题。

错误处理:在批量插入过程中,一旦发生错误,需要有相应的错误处理机制,确保数据的准确性和完整性。

实用案例对比分析

假设需要将一个包含10,000条记录的CSV文件导入到MySQL数据库中,分别采用拼接SQL语句、saveBatch()方法和LOAD DATA INFILE进行操作,通过对比发现,LOAD DATA INFILE方法耗时最短,其次是saveBatch()方法,而拼接SQL语句所需时间最长,这一结果充分证明了在处理大数据量导入时,选择正确的方法对提高效率的重要性。

相关问答FAQs

Q1: 什么情况下推荐使用LOAD DATA INFILE方法?

A1: 当需要导入的数据量非常大,且数据已存储在文件中时,推荐使用LOAD DATA INFILE方法,这种方式直接将文件内容导入数据库,避免了网络传输的开销,是效率最高的一种方式。

Q2: 如何选择合适的批量提交大小?

A2: 批量提交的大小需要根据实际的数据库性能、网络状况以及数据量来综合考虑,可以从几千到几万条记录作为一个批次进行尝试,通过实际测试来确定最佳的批量大小。